10月18日,DeepMind發布了新一(yī)代的AlphaGo Zero,一(yī)個不再需要人類,基于自學而不斷成長的AlphaGo。人工(gōng)智能,離(lí)自己創造通用算法,攻克最艱深的科學問題,比如自己設計藥品、創建更精确的氣象模型,都更近了一(yī)步。

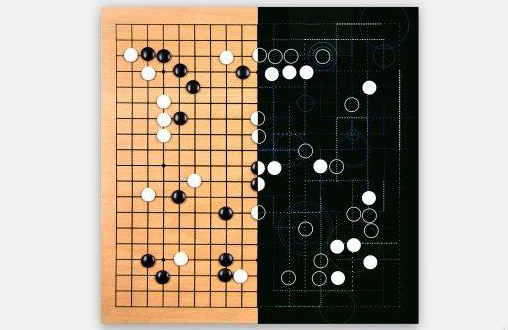

上一(yī)版打敗了柯潔的AlphaGo,已經展現了超人類的圍棋能力,但是,它依舊(jiù)需要人類知(zhī)識的幫助,比如,它學習的超過十萬盤人類棋局,作爲它知(zhī)識體(tǐ)系的基礎。而現在的AlphaGo Zero,僅僅需要程序員(yuán)輸入最基本的圍棋規則,就可以摸索出完整的圍棋下(xià)法,并超越前者。 從DeepMind在《自然》雜(zá)志(zhì)上發表的論文來看,它的所有練習,都由和自己下(xià)棋來完成。一(yī)開(kāi)始,隻是随便落子。就好像所有剛剛下(xià)圍棋的小(xiǎo)朋友一(yī)樣。不過,很快,Zero就自己發現了圍棋一(yī)些成熟定式,從業餘選手轉化爲專業棋手的下(xià)法。

上一(yī)代的AlphaGo有兩個分(fēn)開(kāi)的學習模型,一(yī)個專門用來評估當下(xià)的形勢和棋局,另一(yī)個給出可能的下(xià)幾步走法。而後,AlphaGo從中(zhōng)挑選出可能的走法,讓這些走法在第三個模塊中(zhōng)實驗,模拟出不同的結果。Zero則是單個的、更加強勁的人工(gōng)神經網絡,在評估棋局的同時,給出新的建議走法。它的整套搜索模塊,都變得更加簡潔。在自己和自己下(xià)棋的過程中(zhōng),Zero勝利的一(yī)方就會發現那些不同的定式,自我(wǒ)(wǒ)進行選擇、然後系統,再下(xià)、再升級,以此類推上百萬次。

Zero除了是一(yī)個更佳的棋手,作爲一(yī)個人工(gōng)智能,它還有着其他比前代AlphaGo更好的性能。首先,它所需的計算能力更小(xiǎo)。相比上一(yī)代需要48個TPU,Zero需要的隻有4個。當你需要将AlphaGo的能力放(fàng)到其他更實際的領域中(zhōng)去(qù)的時候,它所節省的運算容量,将帶來更大(dà)的便利性。其次,作爲一(yī)個自我(wǒ)(wǒ)學習的模範,Zero在開(kāi)發新的算法的時候,将不再需要大(dà)量的數據做支撐,在現階段的AI研究中(zhōng),又(yòu)是一(yī)大(dà)突破。目前我(wǒ)(wǒ)們看到的AI的結果,很多都是在大(dà)量的廉價計算能力和數據的基礎上實現的。它能夠給讓AI實現新的功能,卻讓它同時缺乏持續性。

Zero的進化,讓人們看到了僅僅依靠算法,就達到重大(dà)突破和進步的可能性。即使從一(yī)些相對陳舊(jiù)的信息中(zhōng),人工(gōng)智能也可能發現全新的、人類從未開(kāi)發到的方向。

不過,Zero是一(yī)個搜索不同的可能性,選取最佳路徑來實現的模式,依舊(jiù)展現出了AI技術的局限性。畢竟作爲一(yī)個有規則的棋類遊戲,對于計算機來說更有優勢。阿爾伯塔大(dà)學的教授Martin muller雖然也認爲Zero的簡潔設計近乎完美,但是在圍棋的限定規則之下(xià),自我(wǒ)(wǒ)學習是不夠的。當人工(gōng)智能完成一(yī)個需要多方面考量的挑戰時,它就會陷入迷惑之中(zhōng)。比如安裝一(yī)個宜家的沙發、設計一(yī)趟旅行。在這些事情上,人類更加依賴抽象、邏輯推理的能力。

當然,着絕不代表Zero的技術不能用到更多的世紀開(kāi)發中(zhōng)。時尚,谷歌已經用這些算法節省了不少的數據中(zhōng)心冷氣錢。DeepMind在上一(yī)個季度,爲整個Alphabet(谷歌母公司)集團,提供了價值四千萬英鎊的服務。DeepMind還打算加AlphaGo Zero的能力用到氣象預測、蛋白(bái)質分(fēn)子折疊等問題上。谷歌的機器學習,也顯示投放(fàng)更精準的廣告的能力。

最後,AlphaGo Zero也會給被它打擊的人類圍棋,輸入一(yī)些新鮮的血液。作爲第一(yī)個被AlphaGo打敗又(yòu)加入DeepMind的專業棋手,樊輝表示,AlphaGo的圍棋雖然看上去(qù)真的很像是一(yī)個圍棋高手,卻有透露出更加自由的氣象。無需局限于人類的知(zhī)識之中(zhōng),Zero給棋手們帶來了全新的走法,新到連AlphaGo自己都想不出來的那種。